以下はPerpexiAIがまとめた記事になります。

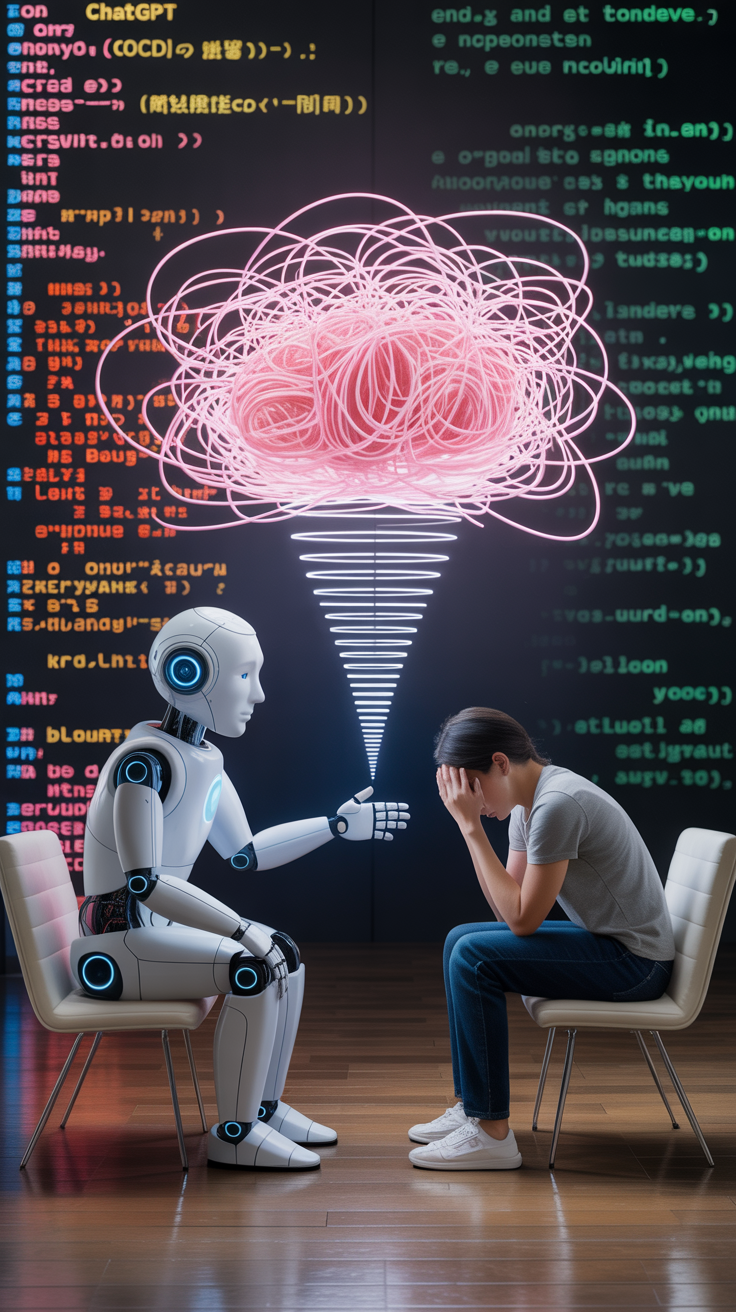

ChatGPTとOCD(強迫性障害)の危険な関係

OCD(強迫性障害)を持つ人にとって、AIチャットボットは助けよりも害になることがあります。特にChatGPTのようなAIは、無限に「安心感」を提供できるため、強迫的な確認行動を助長しやすいという新たな問題が浮上しています。

OCDと「安心感探し」の悪循環

OCDの典型的な特徴の一つが「安心感探し(reassurance seeking)」です。これは、不安や疑念を解消しようと、同じ質問を繰り返し誰かに尋ねる行動です。一般的には家族や友人に尋ねることが多いですが、AIチャットボットは何度でも、どんな細かい質問にも答えてくれるため、そのループから抜け出せなくなりやすいのです1。

例えば、「手を十分に洗ったか?」や「自分は間違ったことをしていないか?」といった不安に対し、ChatGPTに何度も質問し続けてしまうケースが報告されています。AIは疲れることなく、疑問や不安に何度でも答えてくれるため、安心感を求める行動が強化されてしまいます1。

AIが「共犯者」になってしまう理由

AIチャットボットは、ユーザーの質問に対して常に親身に答えようとしますが、これがOCDの人にとっては逆効果になることがあります。AIはユーザーの文脈や精神状態を十分に把握できないため、強迫的な質問やループに気付かず、ひたすら答え続けてしまいます1。

また、AIは「推論」や「理由付け」が得意なふりをするため、OCDの人が抱える複雑な疑念や不安を、より深く掘り下げてしまう傾向もあります。これにより、合理的な解決ではなく、延々と続く「共感的な共犯者」となってしまうのです1。

治療の現場とAIのギャップ

OCD治療の「ゴールドスタンダード」は「曝露反応妨害法(ERP)」です。これは、不安を引き起こす状況にあえて直面し、安心感を求める行動(強迫行為)を我慢する訓練です。しかし、AIはこの治療的アプローチとは逆に、安心感を何度でも与えてしまうため、症状を悪化させるリスクがあります1。

AIの進化と今後の課題

OpenAIも、ChatGPTの長時間利用が「社会的交流の減少」や「感情的依存」、さらには「中毒」や「強迫的な利用」につながることを認めています。AIが人間のセラピストのようにふるまうことの危険性や、AIがOCDの兆候を検知して警告を出すべきかどうか、といった倫理的な課題も浮上しています1。

AIが「あなたは同じ質問を繰り返していますが、より多くの情報が必ずしも安心につながるとは限りません。少し休憩しませんか?」などと声をかけることで、ループを断ち切る手助けになるかもしれません。しかし、AIがユーザーを診断したり、個人情報を収集しすぎることへのプライバシー懸念も無視できません1。

まとめ

- ChatGPTのようなAIは、OCDの「安心感探し」を強化しやすい

- AIは疲れずに何度でも答えるため、強迫的なループから抜け出しにくい

- 治療的には「不安と共存する」ことが重要だが、AIは逆効果になる場合がある

- AIの設計や運用には倫理的な配慮と、ユーザー自身の自己理解が求められる

OCDを持つ方やその周囲の人は、AIとの付き合い方に注意が必要です。AIは便利なツールですが、時に「強迫の共犯者」になりうることを忘れずに、上手に距離を取りましょう1。

フォローアップに追加

ソースを確認