以下は日本語向けまとめ記事(研究解説+量子スケーラビリティの本質整理)です。

中性原子量子コンピュータが抱えてきた「原子が減る=計算が止まる」問題に対し、なぜ今回の成果が決定的なのかを整理しています。

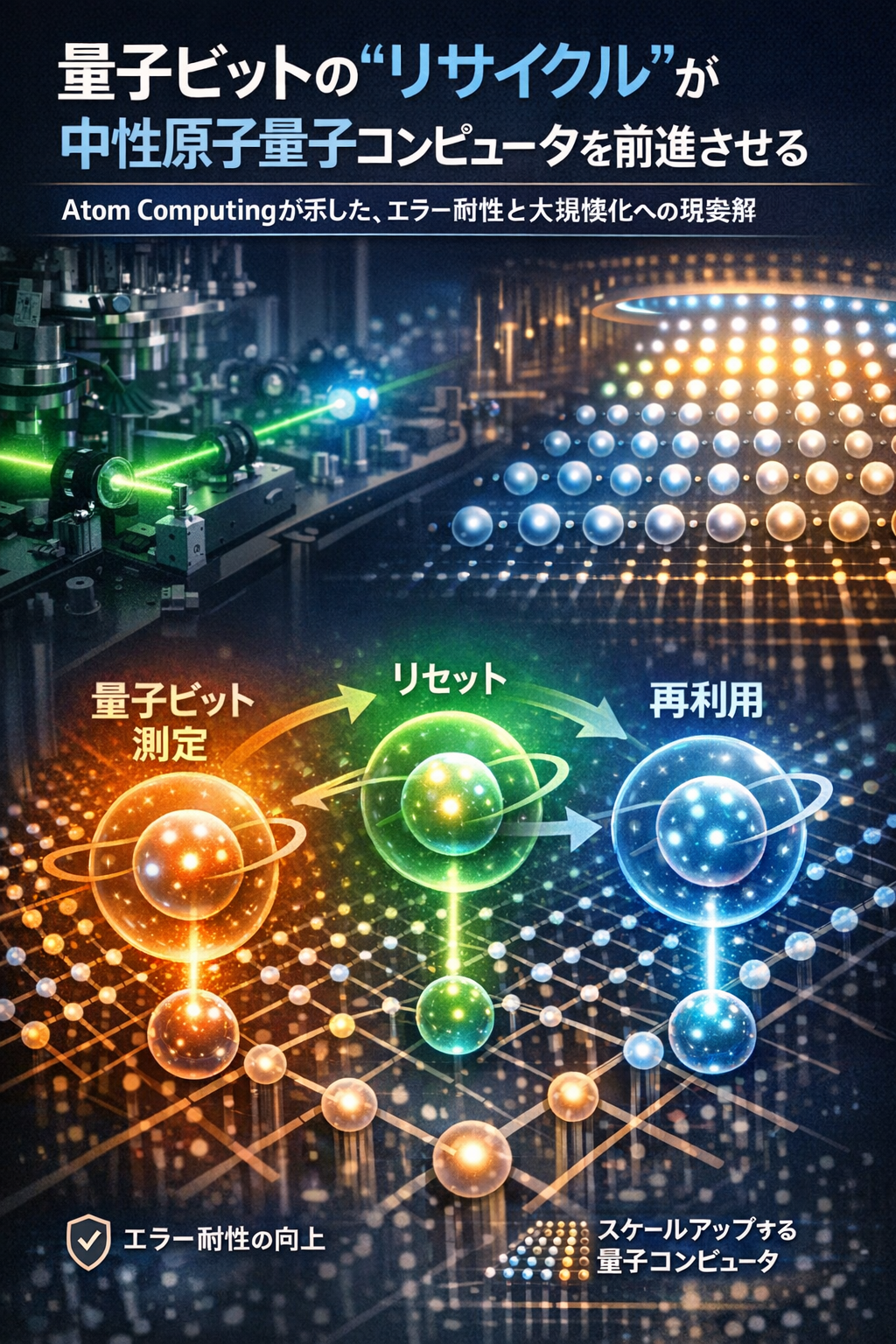

量子ビットのリサイクルが中性原子量子コンピュータを前進させる― Atom Computingが示した、エラー耐性と大規模化への現実解

2025年12月18日、量子物理専門誌 Physics World で報じられた研究によると、

米国の量子コンピューティング企業 Atom Computing の研究チームが、

中性原子量子コンピュータにおける量子ビット(原子)の再利用=“リサイクル” を可能にする手法を実証しました。

この成果は、

量子エラー訂正とスケーラビリティ(大規模化)を同時に阻んできた構造的問題を解決する重要な一歩とされています。

背景:なぜ「原子の損失」が致命的なのか

量子コンピュータの最大の敵はエラーです。

量子ビットは非常に壊れやすく、計算途中で状態が崩れやすい。

中性原子方式のジレンマ

中性原子量子コンピュータは、

- 原子が均一(ばらつきが少ない)

- 大規模配列に向いている

- 長いコヒーレンス時間

といった利点があります。

しかし、従来のエラー訂正では:

- 補助量子ビット(アンサリー)を使う

- 中間測定(mid-circuit measurement)を行う

- 測定に失敗した原子は破棄される

👉 原子を「使い捨て」にする設計だったため、

計算を続けるほど原子が減り、最終的に計算不能になる

という致命的な問題がありました。

新しいアプローチ:「Reduce・Reuse・Replenish」

Atom Computingのチーム(Matt Norcia氏ら)が示したのは、

原子を無駄にしない三段構えの戦略です。

① Reduce(失われる原子を減らす)

- 中間測定を非破壊的に実施

- 計算用レジスタへの影響を最小化

② Reuse(アンサリー原子の再利用)

- 一度測定した原子を冷却

- 再び量子ビットとして計算に復帰

③ Replenish(原子を補充)

- 計算レジスタの外に用意した原子のストックから

- 計算中の量子状態を壊さずに補充

- 原子トラップ(MOT)から連続供給

👉 「原子が減らない量子コンピュータ」

という新しい前提条件を実現しました。

技術的なポイント(なぜ可能だったか)

● イッテルビウム(Yb)原子を使用

- 自然に2つの基底状態を持つ「天然の量子ビット」

- 冷却・観測用の遷移が弱く、他の状態を邪魔しにくい

● 光の影響を巧妙に分離

- 測定対象の原子を物理的に移動

- 計算レジスタと共鳴しない波長を使用

- レーザー散乱による“巻き添えエラー”を回避

● 非破壊測定+再冷却

- 片方の量子状態だけを測定

- 測定後の原子を再冷却して再投入

なぜこの成果が重要なのか

① 多層量子回路が初めて現実的に

Matt Norcia氏は次のように述べています。

「有用な量子計算には、

多数のゲート層を連続して実行する必要があります。

原子数を維持できなければ、それは不可能です」

👉 今回の成果は

“長い量子計算”への前提条件を満たしました。

② 中性原子方式の弱点を克服

これまでの評価:

- 中性原子:スケール向きだが制御が難しい

- 超伝導:制御しやすいがスケールが難しい

今回の研究は、

中性原子の「スケール × エラー管理」問題を同時に前進させています。

③ 産業化への現実味

この研究には、

- Microsoft Quantum

- Stanford University

なども関与しており、

研究室レベルを超えた産業連携が進んでいる点も重要です。

研究コミュニティの評価

ハーバード大学の量子物理学者 Mikhail Lukin 氏も、

「中性原子量子コンピューティング分野における

2025年の重要な技術的前進の一つ」

と評価しています。

編集部コメント(俯瞰)

この研究は、

- 派手な「量子超越」ではない

- しかし “止まらない量子コンピュータ”を可能にする基盤技術

です。

AIで言えば、

- モデル性能より先に

- GPUの安定供給と冷却が重要だったのと同じ。

👉 量子でも「地味な実装技術」が最終的な勝敗を決める

中性原子方式が

数万・数十万量子ビット級へ進むための必須ピースが、

今回の「量子ビット・リサイクル」だと言えるでしょう。